S AI to nie je tak ružové, ako sa zdá. Čaká nás tŕnistá cesta k udržaniu kvality chatbotov?

Je samozrejmé a vlastne trochu smutné, že generatívna AI vzbudila tak veľký rozruch. Je to len ukážka toho, že nie sme na nástup umelej inteligencie všetci pripravení.

Avšak sa začalo ukazovať, že umelá inteligencia nie je pripravená ani sama na seba. Začali sa totiž ozývať hlasy varujúce pred vyčerpaním prirodzených dát.

Dáta hrajú v ekonomike umelej inteligencie ústrednú úlohu a sú životne dôležitou silou modelu, ako v základnej funkcii, tak v kvalite; čím prirodzenejšie – napríklad ľuďmi vytvorené – dáta, na ktorých sa dá systém AI trénovať, tým lepší sa tento systém stáva.

Nanešťastie pre spoločnosti pracujúce s umelou inteligenciou sa ukazuje, že zdroje prirodzených dát sú obmedzené.

Ako poznamenáva Rita Matulionyte, profesorka práva informačných technológií na austrálskej Macquarie University v eseji pre The Conversation, „výskumníci umelej inteligencie už takmer rok na tento fakt upozorňujú. Jedna minuloročná štúdia výskumníkov z organizácie pre predpovede umelej inteligencie Epoch AI odhaduje, že spoločnostiam s umelou inteligenciou by mohli dochádzať vysoko kvalitné textové tréningové dáta už v roku 2026, rovnako ako obrazové zdroje, ktoré vyschnú neskôr.“

Originál článku tu.

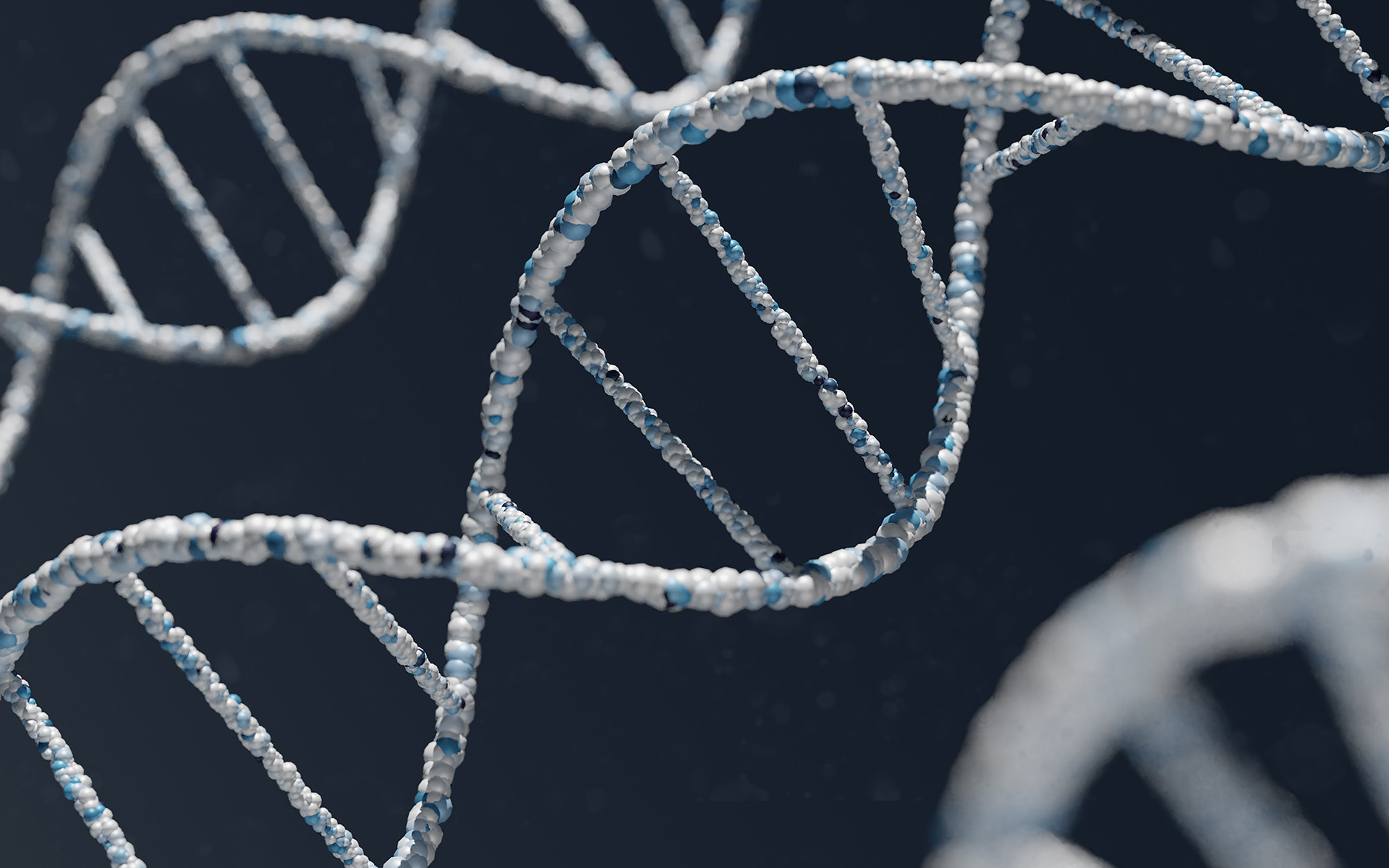

Ponúka sa možnosť použitia syntetických dát alebo dát generovaných modelmi umelej inteligencie, ale ani to nemusí byť životaschopné riešenie. Použitie syntetického obsahu by totiž mohlo v skutočnosti úplne zničiť daný model; existuje určitý výskum, ktorý ukazuje, že trénovanie modelov umelej inteligencie na obsahu generovanom umelou inteligenciou spôsobuje zreteľný inbredný efekt – poruchy pri krížení medzi príbuznými jedincami.

Tým, ako je zrazu AI všadeprítomná, rastie aj syntetický obsah, ktorý produkuje. Paradoxné je, že práve tieto syntetické výstupy môžu byť tiež najväčšou hrozbou generatívnej umelej inteligencie. Zjednodušene povedané, využívaním svojich vlastných výstupov ako dát, môže AI úplne zhlúpnuť.

Prvý mne známy signál je z februára tohto roku, keď výskumník z Monash University Jathan Sadowski napísal: „…. Zo systému silne trénovaného na výstupoch iných generatívnych AI sa stáva inbredný mutant, pravdepodobne s prehnanými, grotesknými rysmi“.

Výskumníci strojového učenia Sinou Alemohammad a Josue Casco-Rodriguezom, obaja doktorandi na katedre elektrotechniky a počítačového inžinierstva Rice University a ich dohliadajúci profesor Richard G. Baraniuk v spolupráci s výskumníkmi zo Stanfordu nedávno publikovali fascinujúci (aj keď doteraz nerecenzovaný) článok na túto tému nazvaný „Self-consuming Generative Models Go MAD“. Pozn. MAD je skratka pre Model Autophagy Disorder.

Rozhovor s výskumníkmi tu.

Baraniuk: „Povedzme, že existujú spoločnosti, ktoré z akéhokoľvek dôvodu – možno je lacnejšie používať syntetické dáta alebo jednoducho nemajú dostatok skutočných dát – hodia opatrnosť za hlavu. Hovoria: "budeme používať syntetické dáta." Čo si neuvedomujú je, že pokiaľ to budú robiť dlho, syntetické dáta sa začnú vzďaľovať realite. To je tá vec, ktorá je naozaj najnebezpečnejšia a možno si ani neuvedomujete, že sa to deje. Tým, že sa vzďaľujete od reality, mám na mysli, že vytvárate obrazy, ktoré budú čím ďalej tým viac monotónne a nudné. To isté sa stane aj s textom. V jednom experimente, ktorý sme urobili, namiesto toho, aby sa rozdiely výstupov zosilneli, všetky obrázky splývajú v podstate do rovnakej podoby. Je to úplne šialené.“